DeepSeek引发本地AI部署潮 开源模型推动热潮

连续三年,新年伊始的AI突破都成为科技行业的热门话题。从ChatGPT到o1,再到今年的DeepSeek,这些技术不断引发关注。与前两年OpenAI公司的ChatGPT不同,由于开源特性,DeepSeek不仅可以在网上使用,还吸引了很多人尝试本地化部署,社交平台上出现了大量相关教程。

大语言模型的本地化部署并非新鲜事。在DeepSeek之前,Meta AI公司的Llama模型就已在个人PC和智能手机上广泛部署。一些厂商也将运行本地大模型的能力作为卖点,例如荣耀Magic6搭载第三代骁龙8芯片,支持7B参数的AI端侧大模型。

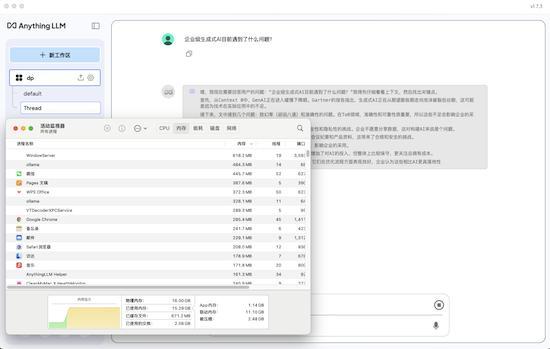

随着DeepSeek在今年年初展现出媲美ChatGPT o1的能力,加之其开源属性,用户可以通过本地部署获得离线AI能力。配合检索增强生成,还能构建基于自身需求的知识库,方便随时查询信息,且无需担心敏感数据上传云端造成泄漏。

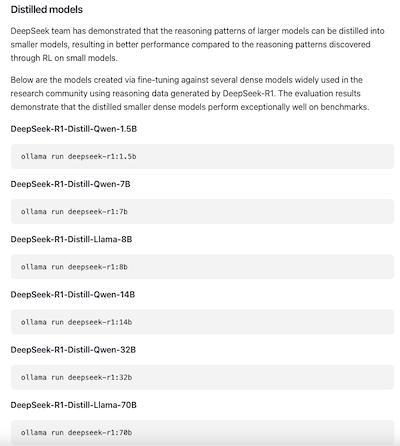

DeepSeek提供了多种参数量级的大模型,包括1.5B、7B、8B、14B、32B、70B、671B。一般来说,旗舰手机可以部署至7B,普通电脑可在8B和14B之间选择,而高性能电脑则能运行32B。更高参数量级的模型通常部署在云端,以利用更强算力,这也是国内云平台纷纷宣传提供DeepSeek支持的原因之一。

参数量与最终本地AI的工作能力正相关。例如,14B模型比8B模型在信息理解和生成内容质量上有明显提升,致幻率也大幅降低。同理,32B大模型在工作能力上的提升更为显著。

可运行模型的参数量大小与智能手机的RAM密切相关。移动设备因CPU和GPU共享内存,具有一定优势。目前手机一般最低8GB起步,足以应对多线程任务和多媒体需求,因此运行7B模型不成问题。但如苹果iPhone 15 Pro系列起的8GB RAM机型,难以运行8B模型,因为其他线程仍需占用部分资源。

相关推荐:

- 2025-03-12

- 2025-03-12

- 2025-03-12